Dass soziale Plattformen wie Facebook, Instagram oder Discord gezielt genutzt werden, um (junge) Menschen zu radikalisieren und zu rekrutieren, ist seit Jahren gut erforscht. Von YouTube wissen wir zudem: Videos mit skandalösem Content – also Inhalten, die sich gerade noch so im Rahmen der Legalität befinden – erfahren tendenziell mehr Interaktion, da starke Emotionen wie Wut, Trauer und Angst gezielt angesprochen und getriggert werden.

Einer der maßgeblichen Unterschiede und das Erfolgsrezept der Plattform TikTok liegt in der Logik der App. So grenzt sich TikTok bewusst vom „Social-Circle“-Prinzip ab – also der Logik, den Inhalt von gefolgten Nutzer*innen als Erstes zu sehen. Grundlegend ist hier das Prinzip „Content-first“, das darauf abzielt, den Inhalt und nicht die Nutzer*innen in den Vordergrund zu stellen. So können auch Nutzer*innen ohne etablierte Followerschaft und hohe Reichweite immer wieder virale Erfolge feiern. Der Algorithmus bestimmt dabei, welche Videos angezeigt werden.

Im Sog des Algorithmus

Eine Studie der NGO Media-Matters zeigt dabei, wie schnell der TikTok-Algorithmus problematische Inhalte und Filterblaseneffekte fördert: analysiert wurde, wie die Plattform auf den Konsum transfeindlicher Inhalten reagiert. Innerhalb kürzester Zeit lenkte der Algorithmus die Nutzer*in von einer vielfältigen Auswahl an Videos hin zu dem vermeintlichen erwünschten Inhalt. Der Algorithmus begann umgehend, die persönlichen Empfehlungen der Nutzer*in mit hasserfüllten und rechtsextremen Inhalten zu füllen. Das ernüchternde Ergebnis: von insgesamt 360 empfohlenen Videos enthielten 103 trans- und oder homophobe Inhalte, 42 waren frauenfeindlich, 29 rassistisch und ganze 14 Videos riefen zu direkter Gewalt auf.

Inwiefern gerade für junge Menschen solch ein Sog gefährlich sein kann, zeigt auch eine Recherche eines österreichischen Journalisten, der sich als 14-jähriger Nutzer ausgegeben hat. Über eine anfangs scheinbar willkürliche Auswahl an Videos zeigt der Algorithmus schnell Inhalte mit starken Reizen an – Emotionen, Aufreger und/oder Radikales – welche die Nutzer*in zu mehr Interaktion motivieren sollen. Von einem buddhistischen Mönch, der Lebensweisheiten predigt, hin zu einem Chauvinisten, der sich über Veganismus und Frauen lustig macht, zu einer Darstellung von verschiedenen Arten des Messerangriffs und einem O-Ton des verstorbenen rechtspopulistischen Politiker Jörg Haider. Bei einer Interaktion folgt prompt die „Belohnung“ mit mehr menschenfeindlichen Inhalten: weitere Videos, die noch gezielter auf den „persönlichen Geschmack“ ausgerichtet sind.

Die Gefahr in ein sogenanntes „rabbit hole“ (dt. „Kaninchenbau“) zu geraten, also nur noch Inhalt aus gewissen Themenbereichen angezeigt zu bekommen, ist dabei extrem hoch. So kann ein toxischer Kreislauf entstehen: skandalösere Videos rufen Reaktionen bei den Nutzer*innen hervor und werden dadurch wiederum vermehrt vom Algorithmus ausgespielt. Raum für skeptisches Abwägen ist auf der App kaum gegeben. Zu sehr ist die Plattformlogik auf eine unmittelbare Interaktion ausgelegt, zu schnelllebig ist der Feed für ein kritisches Für und Wider.

Somit stellt der Algorithmus und der Filterblaseneffekt in der Medien- und Kommunikationsstrategie demokratiefeindlicher Akteur*innen eine Waffe zur Radikalisierung dar: „Mittlerweile radikalisieren sich fast 80 Prozent jener, die sich radikalisieren, im Internet, über soziale Medien, auf Plattformen wie TikTok und Twitch“, so der Terrorismusexperte Nicolas Stockhammer. Durch die Filterblase nehmen Nutzer*innen diesen Ausschnitt als vermeintliche Wahrheit oder Normalität wahr, da sie kaum mehr Inhalte angezeigt bekommen, die nicht in ihr Weltbild passen. Eine Dynamik, die wir aus der Analyse Rechts alternativer Medienwirklichkeiten etwa auf Telegram mehr als zur Genüge kennen.

Von der Normalisierung zur Dehumanisierung

Die genauen Radikalisierungsprozesse unterscheiden sich je nach Individuum und Weltsicht , haben aber vergleichbare Momente und Muster. Dem australischen Wissenschaftler Luke Munn zufolge durchlaufen digitale Radikalisierungsprozesse meist drei sich überschneidende, nicht immer geradlinige kognitive Phasen.

In der ersten Phase der Normalisierung kommen Nutzer*innen mit radikalen Inhalten erstmals in Kontakt. Der eigentliche Inhalt wird dabei oftmals durch Witz und Ironie oder andere plattformspezifische Ästhetik (Trends, Challenges, etc.) verschleiert.

In der folgenden zweiten Phase der Akklimatisierung wird sich an die angezeigten radikalen Inhalte gewöhnt. Es werden am Anfang noch Meinungen übernommen, die anschlussfähig an die sogennante “Mitte der Gesellschaft” sind (z.B. eine Kritik am „gendern“ – also der Anwendung einer geschlechtergerechten Sprache). Mit der Zeit verlieren Nutzer*innen an Empathiefähigkeit und es werden durch den befeuerten Algorithmus zunehmend radikalere Inhalte ausgespielt. Eine Veränderung der Wahrnehmung ist die Folge, welche in der Szene „red pilling“ genannt wird. Diese Selbstbezeichnung radikalisierender Menschen, angelehnt als popkulturelle Referenz an den Film „Matrix“, bezeichnet das Phänomen, immer weiter nach der vermeintlichen Wahrheit zu suchen und kein “Schlafschaf“ mehr sein zu wollen. Das öffnet die Türen für immer extremere Inhalte und Verschwörungsideologien.

Und dies führt schließlich zur dritten und letzten Phase: die Dehumanisierung. Menschen werden nicht mehr als Individuen angesehen, sondern als gleichförmige Wesen, mit der gleichzeitigen Aberkennung jeglicher Menschlichkeit und den damit einhergehenden Rechten (z.B. im Antisemitismus). Der Weg zu einem potenziellen Handlungsdrang, z.B. in Form einer Gewalttat, wird dadurch geebnet. Als einfache Veranschaulichung kann das Zwiebelprinzip dienen, wobei die sich radikalisierenden Personen verschiedene Schichten durchlaufen, neue vermeintliche Wahrheiten erschließen und immer weiter in den sogenannten „Kaninchenbau” eintauchen.

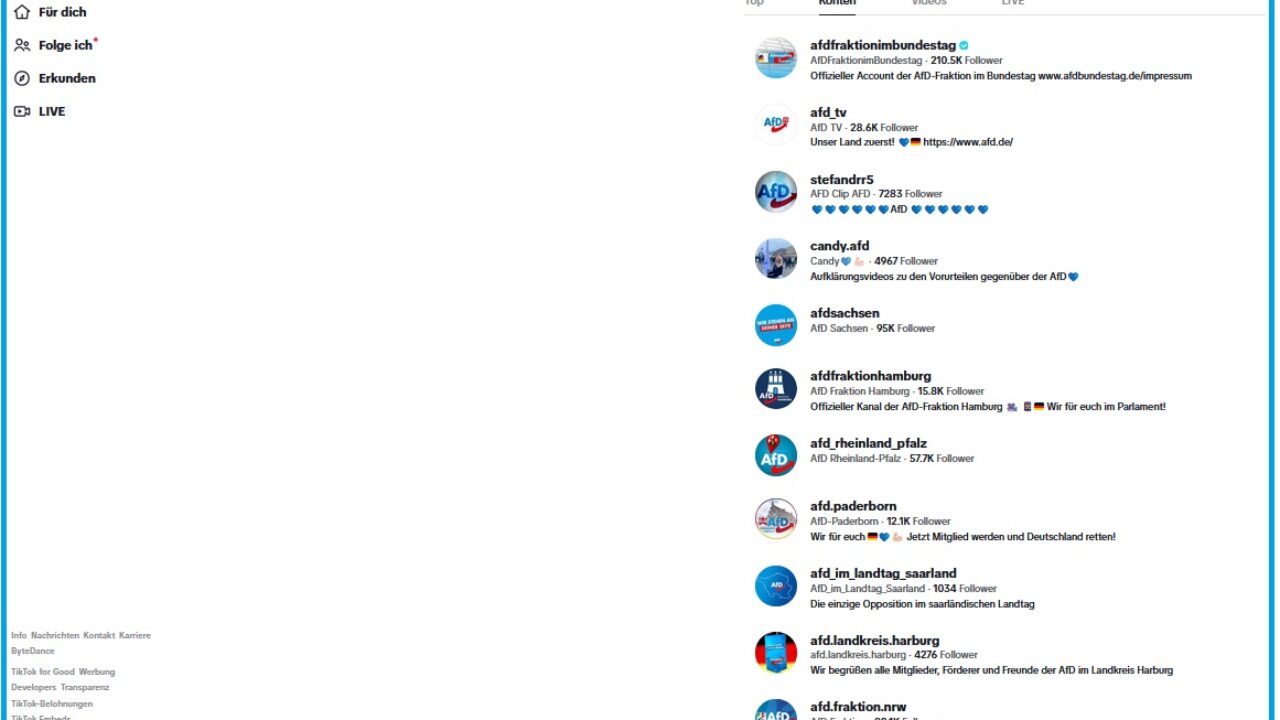

Antidemokratische Akteur*innen nutzen dabei verschiedene Strategien, um möglichst effektiv ihre Ideologien zu verbreiten. Die Nutzung von Desinformationen und Hate Speech (siehe auch Newsletter #3 und #6) sind dabei besonders effektiv im Wettbewerb der Aufmerksamkeiten. Inwiefern die rechtsextreme Radikalisierungsmaschine auf TikTok funktioniert und was das Ganze mit Hundepfeifen und Lifestyle zu tun hat, beleuchtet der Artikel „Wie geht rechtsextreme Mobilisierung auf TikTok?“ unserer Kolleg*innen von pre:bunk.

Und wie geht TikTok mit extremistischen und menschenfeindlichen Inhalten um? Auf eine Anfrage des MDR äußert sich TikTok floskelhaft: „Es gibt keinen Platz für gewaltbereiten Extremismus auf TikTok, und wir arbeiten intensiv daran, Inhalte zu entfernen, die das unterhaltsame Erlebnis untergraben, das die Menschen auf unserer Plattform erwarten“. Zwar ist eine Absicht des Handlungsbedarfs vonseiten des Unternehmens gegeben, angesichts der Vielzahl radikaler Inhalte bedarf es hier eindeutiger und vor allem konkreter Maßnahmen.

Präventionsarbeit mit jungen Menschen

Radikalisierung ist oft ein schleichender Prozess. Um diesen Jugendlichen besser verständlich zu machen, eignet sich insbesondere das Spiel „Decount“: Interaktiv begleitet man dabei eine von vier jugendlichen Personen, die im Spielverlauf vor verschiedenen Entscheidungen stehen. Je nach Entscheidung entwickelt sich ihre Geschichte in eine radikale Richtung oder nicht.

Ziel ist es, das kritische Bewusstsein von jungen Menschen zu stärken und damit für Radikalisierungsmechanismen zu sensibilisieren, bevor diese überhaupt greifen können. Das Spiel eignet sich für die Nutzung auf dem Smartphone für Jugendliche ab 16 Jahren und wird durch pädagogisches Begleitmaterial zur Thematisierung im Unterricht oder der Jugendarbeit ergänzt. Weitere Informationen, den Link zum Spiel und weiterführende Lehrmaterialien findet ihr hier.