Wer einen Motivationschub braucht, um sein Engagement im Netz als sinnvoll aufrechterhalten zu können, auch wenn es manchmal nicht viel zu bewegen scheint, der ist bei Medienwissenschaftler Berhard Pörksen richtig. Sein re:publica-Panel hieß „Abschied vom Netzpessimismus. Die Utopie der redaktionellen Gesellschaft“ und trug im Kern die Idee: Dystopien und Narrative des Niedergangs sind zwar aktuell allgegenwärtig – aber sie nützen uns nichts. Wer der Meinung ist, das Ende der liberalen der Demokratie der Welt und die Wiederkehr des Faschismus steht bevor, findet dafür zwar viele Indizien, aber sie führen in die Resignation und werden schlimmstenfalls eine selbsterfüllende Prophezeiung. Dabei brauche die Mitte der Gesellschaft doch eher: Mut. Auch die Kommunikationsdystopie führt in die Resignation. Wer nur ein postfaktisches Zeitalter voller Respektlosigkeit, Desinformation und Lügen sieht, kann nur entmutigt werden: Was kann man dann noch tun? Als drittes macht Pörksen die Manipulatonsdystopie aus: Wer die Menschheit nur noch als manipuliert von Algorithmen und Framing ansieht, angesichts dessen sich man sich von Aufklärung, Vernunft und Moral nur verabschieden könne, macht sich handlungsunfähig. „Man denkt sich selbst wehrlos“, sagt Bernhard Pörksen: „Man muss warnen, auch laut, aber nicht die Entmündgung durch eine höhere Ordnung propagieren, in der das Individuum, die Überraschung, die Autonomie nicht mehr vorkommen.“

Statt „Aufklärungspessimismus“ wünscht er sich eine „redaktionelle Gesellschaft“ mit Vertrauen in mündige Bürger*innen: „Denn wir retten die Demokratie nicht durch Abschaffung zentraler Prinzipien.“ Knackpunkt bleibt dabei die Frage: Wie gegen Aggressionen, Hass und Desinformation kämpfen, aber Informationsfreiheit und Mündigkeit hochhalten? Pörksen sieht darin eine „Bildungsherausforderung“: Die Ideale des guten Journalismus müssten Element der Allgemeinbildung der Gesellschaft werden: Fakten prüfen, auch die andere Seite hören, Ereignisse nicht größer machen, als sie sind, Relevanz einschützen, Proportionalitäten wahren, Fehler zugeben und transparent machen, skeptisch mit Macht umgehen, Ungerechtigkeiten zeigen. Diese „Medienmündigkeit“ soll durch ein entsprechendes Schulfach umgesetzt werden. Journalismus müsse derweil einen Pakt mit dem Publikum eingehen und transparenter arbeiten, damit die Leser*innen die Qualität der Informationen einschätzen können. Ähnliches gelte für Plattformen im Netz: Sie müssten eine transparent publizierte Form der Plattformregulierung finden, die Kommunikationsfreiheit und den Kampf gegen Desinformation in Einklang bringen – Pörksen erläuterte allerdings nicht wirklich, wie das gelingen soll. Trotzdem hat er mit dem Aufruf zur Aktion recht: „Zukunft wird von Menschen gemacht. Von uns. Wir können unsere Ohnmacht beschwören, in Fatalismus verfallen – aber damit verdrängen wir nur, dass es trotzdem wir sind, die entscheiden.“

Datenanalyst Luca Hammer führt im Panel „Wut in Zeitlupe: Analyse von Empörungswellen auf Twitter“ in die interessante Welt der Twitteranalysen ein. Wenn ein Shitstorm aufkommt: Wo fängt er an? Warum? Wer macht mit? Wie viele sind das? Sind das Menschen oder Bots? „Es sind übrigens meistens keine Bots“, sagt Hammer, „und zu der Frage: Wer sind die Menschen, die da posten, kann ich auch nichts sagen: Ich analysiere nur Accounts“. Denn wer hinter einem (oder vielen) Twitterprofil ist nicht Teil der Datenlage. Trotzdem ist eindrucksvoll, was mit Twitteranalyse an Erkenntnissen zu gewinnen ist. Etwa: Wo ist der Ausgangspunkt einer Empörungswelle? Wer teilt die Empörung dann – in welcher Reihenfolge? Wer sind zentrale Akteur*inne (etwa der rechtsextremen Szene), die auf Twitter viel Reichweite haben und Stimmung machen gegen zivilgesellschaftliche Akteur*innen? Für seine Analysen muss Hammer schnell sein, denn über die Standard-Schnittstelle, die Twitter Forscher*innen anbietet, sind Daten nur 7 bis 10 Tage verfügbar. Aus den Daten kann man eine Netzwerkanalyse erstellen: Wer steht in Verbindung durch Retweets oder sich folgen? Wo gibt es Gruppen, „Empörungsknoten“? Im Fall einer konkreten Empörungswelle gegen ZDF-Journalistin Nicole Diekmann zeigt Luca Hammer: Wo kamen die verbalen Angriffe her? Aber auch: Wie schnell reagierten Accounts, die Gegenrede betrieben und sich mit Diekmann solidarisierten? Und das ist eine sehr schöne Visualisierung: Wie viel mehr die solidarischen, demokratischen Menschen hier sind – und wie klein der giftige braune Knoten dagegen wirkt. Das hilft auch zur Motivation.

Wer es selbst ausprobieren möchte: Luca Hammer empfiehlt Tools auf seinem Blog:

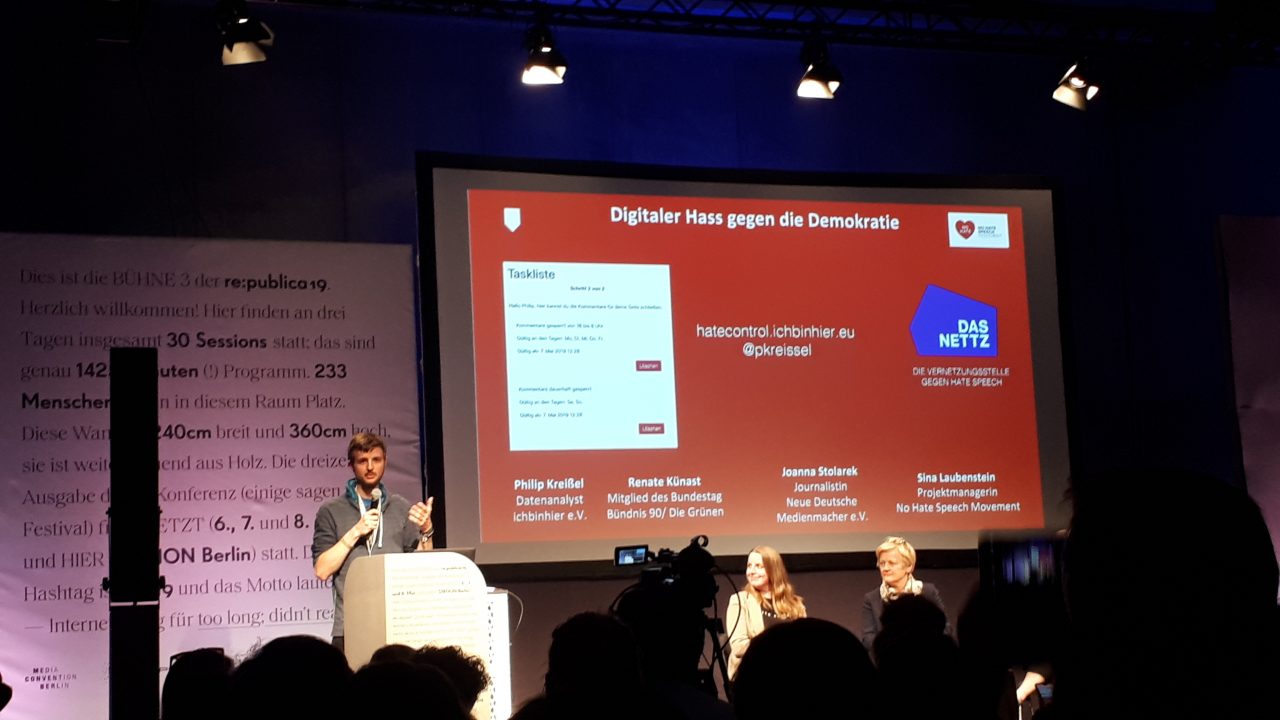

Erkenntnisse zur Wirkmächtigkeit von Hass im Netz gab es beim Panel „Digitaler Hass gegen die Demokratie“. Das „No Hate Speech Movement“ hat etwa mit Betroffenen gesprochen, die viel Hate Speech erhalten, und festgestellt: Am meisten werden Beleidigungen versendet, dann folgen Schadenswünsche, Vergewaltigungswünsche, Todeswünsche, Drohungen und Morddrohungen (in der Reihenfolge). Manche Betroffenen zeigen bis zu 30 Mal (!) im Wochen-Schnitt Hate Speech bei der Polizei an – sind sich aber zugleich unsicher darüber, ob das etwas bringt, weil bisher in den meisten Fällen die Täter*innen nicht ermittelt werden. Was dagegen praktisch hilft: Solidarität. „Das geht an uns alle“, sagt Sina Laubenstein vom „No Hate Speech Movement“, „eine solidarische Nachricht – die kann auch nichtöffentlich per Messenger oder PN sein – hilft sofort und das ist uns allen möglich.“

Philipp Kreißel von der Gruppe #ichbinhier hat sich dagegen die Täter*innen angesehen und festgestellt: Für viele Hasskommentare auf großen Medienseiten sind sehr aktive Accounts verantwortlich, die die Hasswelle massiv wirken lassen: Nur 5 % der Accounts, die Hasskommentare auf den untersuchten Medienseiten verfassten, war verantwortlich für 50 % der Hasskommentare. „Das ist eine Strategie“, sagt Kreißel, „um in die Filterblase der Mitte einzudringen, sich durch Trolling Platz zu schaffen und dann die eigene Ideologie zu platzieren – damit sie dann als ‚Volksmeinung’ erscheint“. Bei Hasskampagnen auf Facebook konnte er erkennen, dass diese oft von miteinander vernetzten Facebookaccounts gefahren werden, wobei etwa die Accounts von IB-Anhänger*innen besonders leicht für Hass-Aktionen zu motivieren sind. Interessant auch: Bei einer Welle von Hasskommentaren gegen den Asta der Uni Köln, der sich für ein Verbot der bei Rechtsextremen beliebten Modemarke „Thor Steinar“ im Unigebäude ausgesprochen hatte, nahmen nur 3 % der Hasskommentare diese Thema überhaupt auf: „Es geht vor allem darum, Menschen zu bedrohen. Es wird ein Vorwand gesucht, was, ist eigentlich egal. Es geht nur um den Akt der Bedrohung, hier um die Bedrohung linksliberaler Studierender.“

Gemeinsam mit „Das Nettz“ hat Kreißel übrigens ein Tool entwickelt, dass Betroffenen von Hassrede praktisch hilft: Mit „Hatecontrol“ lassen sich auch für Facebook-Seitenbetreiber*innen für einen selbst gewählten Zeitraum – etwa nachts – die Kommentare abstellen.

Mehr hier: hatecontrol.ichbinhier.eu

Und

Heute ist der letzte Tag der re:publica 2019 – also wenn Sie uns besuchen möchten, dann heute am Stand der Amadeu Antonio Stiftung in Halle 3. Unser Standprogramm finden Sie hier: