Eine vermeintlich zukunftsorientierte Ideologie macht menschenfeindliche Ideen und gefährliche Denkmuster wie soziale Kälte, Eugenik, Abwertung von menschlichem Leben und Überwachung salonfähig.

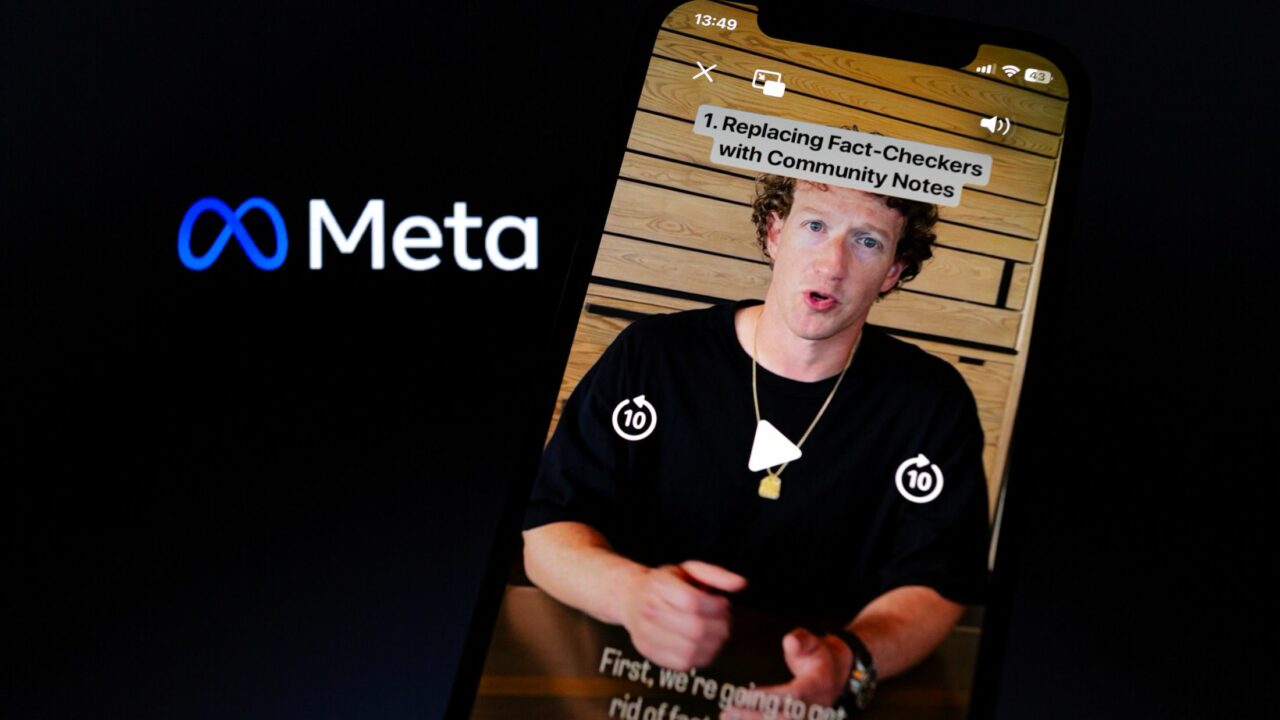

Wie milliardenschwere Tech-Faschisten mit philosophischer Menschenfeindlichkeit die Welt retten wollen.

Angenommen, irgendwo auf der Welt lebt ein respektierter Wissenschaftler, der als Stimme seiner Generation gilt und bahnbrechende Entdeckungen zu machen verspricht, jedoch tragisch ums Leben kommt. Anderswo sterben Millionen Menschen infolge einer Hungersnot, ausgelöst durch Dürre, was ebenfalls zu massiver Flucht führt. Was wiegt schwerer? Longtermistischer Logik zufolge ist der einzelne Verlust des Wissenschaftlers ein „existentielles Risiko“, da sein Beitrag zur Abmilderung möglicher Katastrophen und zur langfristigen Sicherung der Menschheitszukunft fehlen würde. Die Hungersnot hingegen ist für Longtermist*innen zwar ein tragisches Ereignis, das aber nicht unbedingt vorrangig behandelt werden muss. Denn die Auswirkungen auf die langfristige Sicherung der Menschheitszukunft scheint geringer.

Die Langfristigkeitstheoretiker*innen haben einen eigenen melodramatischen Jargon entwickelt: „Existenzielle Risiken“ stehen für jede Möglichkeit der Zerstörung des zukünftigen Potenzials der Menschheit und „existenzielle Katastrophen“ für jedes Ereignis, das dieses Potenzial tatsächlich zerstört. Das theoretische Regelwerk berechnet kühl, was ein Menschenleben nach Nützlichkeitskriterien wert ist. Das klingt dann im longtermistischen Fachjargon ungefähr so:

Selbst wenn wir die konservativste dieser Schätzungen heranziehen und dabei die Möglichkeit der Weltraumkolonisation und von Software-Gehirnen außer Acht lassen, stellen wir fest, dass der erwartete Verlust einer existenziellen Katastrophe größer ist als der Wert von 10 hoch 16 Menschenleben. Das bedeutet, dass der erwartete Wert einer Verringerung des Existenzrisikos um nur ein Millionstel eines Prozentpunktes mindestens das Zehnfache des Wertes von einer Milliarde Menschenleben beträgt.

Longtermism, zu deutsch Longtermismus, heißt der philosophische Trend, der Silicon Valley und Milliardäre wie Peter Thiel und Elon Musk seit Jahren begeistert. Longtermism ist eine Ideologie, die die langfristige Zukunft der Menschheit priorisiert. Sie bewertet globale Ereignisse und Krisen nach ihrem Einfluss auf das Überleben und die Chancen künftiger Generationen. Dieser Ansatz, theoretisch geprägt von Denkern wie Nick Bostrom, der auf den ersten Blick ethisch unbedenklich erscheinen mag, offenbart bei näherer Betrachtung allerdings menschenfeindliche und potenziell gefährliche Denkstrukturen, die etwa von autoritären Regimen oder rechtsextremen Akteuren vereinnahmt werden könnten. Der Longtermismus birgt das Risiko, menschliches Leben ungleich zu bewerten, was in sozialer Kälte und Menschenfeindlichkeit münden kann.

Innerhalb des Denkschemas der Langfristigkeitsprediger könnte etwa eine Dürrekatastrophe, die Millionen tötet, als irrelevant eingestuft werden, wenn sie nicht als langfristig bedeutsam angesehen wird. Der Tod des Wissenschaftlers hingegen, der die Menschheit in Bereichen wie künstlicher Intelligenz oder Klimaschutz vorangebracht hätte, könnte als unersetzlicher Verlust gelten. Ganz konkret könnten Geflüchtete oder benachteiligte Menschen als Teil der gegenwärtigen Generation abgetan werden, deren Probleme nicht ausreichend dringlich erscheinen, um priorisiert zu werden. Diese Logik der Quantifizierung kann eine Normalisierung der Gleichgültigkeit gegenüber real existierendem menschlichem Leid vorantreiben.

Wertigkeit menschlichen Lebens, globale Überwachung und Eugenik?

Menschen werden nach ihrem Beitragspotenzial für die Zukunft bewertet. Hochbegabte Individuen, also Menschen mit außergewöhnlichem Intellekt, hohem sozialem Kapital oder besonderen Talenten, werden vordergründig für ihren potenziellen Einfluss auf Weltereignisse priorisiert. Menschen ohne solche Merkmale können hingegen systematisch abgewertet werden, da sie in der Menschheitsgeschichte keine sichtbaren Spuren hinterlassen würden.

In The Vulnerable World Hypothesis betont Zukunftsforscher Nick Bostrom die Bedeutung von technologischen und wissenschaftlichen Fortschritten, um die Menschheit vor existenziellen Bedrohungen zu schützen. Seine Ideen könnten nicht nur theoretisch missbraucht werden, um etwa globale Überwachung durch neue Technologien zu rechtfertigen – Milliardäre wie Peter Thiel verfolgen solche Ziele mit Projekten wie Palantir schon aktiv und setzen sie um.

Die Fetischisierung von Intelligenz, ausgedrückt als IQ, als Schlüsselfaktor für die Sicherung der Zukunft, gehört zum festen theoretischen Repertoire der Ideologie. Einige Vertreter des Longtermismus sehen im IQ den zentralen Indikator für den Wert eines Menschen. Nicht zufällig finden sich Parallelen zu Ideologien der Ungleichwertigkeit, besonders Rechtsextremismus, zumal künstliche Hierarchien und eugenische Abstufungskriterien zum Einsatz kommen, um die Differenz von Menschen zu erklären. Eugenik spielt dabei eine zentrale Rolle, sei es durch transhumanistische Selbstoptimierung, technologische Augmentation oder schlichtweg wissenschaftlichen Rassismus.

Generell ist der longtermistische Diskurs durchzogen von Fachtermini und aufgeladenen Begriffen, die mantraartig von Theoretiker*innen wiederholt und gegenseitig bestätigt werden. Permanent entstehen neue, hochtrabende, pseudo-ethische Begriffe, die oft nur dazu dienen, die eigene Kälte und Gleichgültigkeit gegenüber menschlichem Leid zu kaschieren. „Existentielles Risiko“ oder „Katastrophe“ wären solche Begriffe. Wer jedoch mehr als einen Vertreter dieser Denkschule liest, stößt immer wieder auf den sogenannten Ripple Effect oder Welleneffekt. Dieser Begriff beschreibt wellenartige Entwicklungen, die nach einem bestimmten Ereignis auftreten. Der Ripple Effect wird beispielsweise von Nicholas Beckstead, einem weiteren Vertreter, herangezogen. Beckstead argumentiert, dass es langfristig sinnvoller sei, reiche Länder zu schützen und zu retten, anstatt ökonomisch schwächere Länder zu priorisieren. Seiner Auffassung nach würde der Ripple Effect in reichen Ländern einen deutlich größeren Mehrwert erzeugen:

Die Rettung von Leben in armen Ländern kann deutlich geringere Auswirkungen haben als die Rettung und Verbesserung von Leben in reichen Ländern. Und warum? Reiche Länder verfügen über wesentlich mehr Innovationen, und ihre Arbeitnehmer sind wirtschaftlich viel produktiver. Es erscheint mir jetzt plausibler, dass die Rettung eines Lebens in einem reichen Land wesentlich wichtiger ist als die Rettung eines Lebens in einem armen Land, wenn alle anderen Dinge gleich sind.

Es erinnert an Alexander Gaulands vielzitierte Dogwhistle über die zwölf Jahre Nationalsozialismus als Vogelschiss in der deutschen Geschichte, wenn Bostrom höchstpersönlich schreibt: „Die menschliche Spezies hat lange Erfahrung mit gefährlichen Tieren, feindlich gesinnten Stämmen und Individuen, giftigen Lebensmitteln, Autounfällen, Tschernobyl, Bhopal, Vulkanausbrüchen, Erdbeben, Dürren, Kriegen, Grippeepidemien, Pocken, Pest und AIDS. (…) Selbst die schlimmsten dieser Katastrophen waren nur kleine Wellen auf der Oberfläche des großen Meeres des Lebens.“ Also ein Vogelschiss in der Menschheitsgeschichte und damit nichts weiter als eine ungemütliche Anekdote, die es schnell zu überwinden gilt, ohne sich das Ausmaß an Leid, Genozid, Verderben und systematischer Vernichtung genau anzuschauen.