Es war ein Jahr, in dem die gewachsenen Online-Infrastrukturen der AfD, ihrer Vorfeldakteur*innen und ihrer Subkulturen als KI-Slop den digitalen Raum dominierten. Hinzu kam eine jahrelang verfestigte Astroturfing-Architektur, die politische Stimmung und Reichweitenströme nahezu reibungslos aus denselben Systemen bezog und die Grenze zwischen orchestrierter Mobilisierung und organischer Empörung verwischte.

Gleichzeitig wurde diese Infrastruktur durch reaktionäre gegenkulturelle Ideologisierung angereichert. Etwa Pronatalismus, Cyberlibertarismus oder Longtermismus bildeten 2025 die ideologische Kulisse, in der rechte Akteur*innen nicht nur Kulturkampf führten, sondern Zukunftswahnvorstellungen entwarfen. Strömungen, die wir auf Belltower.News in der Textreihe [Gegenaufklärung 2025] untersucht haben, fungierten zunehmend als intellektuelle Legitimationsschicht, die digitale Mobilisierung mit schwulstiger Bedeutung versorgen sollte.

Una Titz leitet den Digitalbereich der Amadeu Antonio Stiftung und ist Monitoring-Expertin. Sie beobachtet unter anderem die Ideologien, die Elon Musk und Co. antreiben.

Online first, mit Affektpeaks und festen Content-Kalendern

Es formierten sich eigenständige, online-first organisierte rechtsextreme Netzwerke mit eigenen Jahresrhythmen, festen Content-Kategorien und strategisch kuratierten Empörungs-Ritualen. Diese Öffentlichkeiten produzierten ihre Themen zyklisch, nach einem festen Kalender, der Affektpeaks planbar machte. Ein Beispiel ist der weitestgehend online organisierte „Stolzmonat“, der jedes Jahr erneut genutzt wird, um antifeministische und queerfeindliche Narrative rund um den CSD digital zu überlagern. Solche Formate existieren inzwischen als kulturelle Pflichttermine innerhalb der rechtsextremen Online-Ökosysteme: wiederkehrende Kampagnen, die Reichweite sichern und Deutungshoheit simulieren, bevor überhaupt politisch debattiert wird.

Diese ritualisierte Struktur zeigt sich ebenso in Gaming-Kulturen, in denen antifeministische Memes und Feindbild-Erzählungen längst zu festen Content-Genres geworden sind. Die antifeministische Behauptung, Gamer wollten „echte Spiele“ statt angeblicher woker Aktivist*innenkultur, wurde 2025 zur Standardunterwanderungsstrategie rechtsextremer Akteur*innen, nach Release neuer Spiele. Auch hier geht es um die Herstellung eigener kultureller Realitäten, in denen antifeministische Normen, Maskulinitätsfantasien und populäre Meme-Referenzen zu einer kohärenten rechten Kulturform verschmelzen.

Rechtsextreme agierten dabei in einer Deutlichkeit professionell, die kaum noch zufällige Überschneidungen zulässt. So etablierten Influencer*innen Newsroom-ähnliche Sendeformate, die Unterhaltung und Kulturkampf miteinander verschmolzen. Livestreams, Straßenumfragen, und Protestbegleitungen dienten als permanente Resonanzräume, die in Echtzeit antidemokratisch umgedeutet wurden. Das Attentat auf Charlie Kirk wurde so binnen Minuten in eine rechte Narrativarchitektur überführt, die maximal emotionalisiert und algorithmisch vervielfacht wurde.

Affektmaschinen, Brainrot-Meme-Ökonomien und Enshittifizierung

Entscheidend für 2025 war die Bedeutung von KI als Beschleuniger alternativer Wirklichkeiten. Mit KI-Slop – mithilfe von KI-Generatoren, leicht zu produzierende Bilder niedriger Qualität – entstand eine Ästhetik endloser Reproduktion, in der politische Bilder, Affekte und Takes in Sekundenschnelle erzeugt werden konnten.

KI-Slop führt zu einem Bedeutungsverlust, weil die Geschwindigkeit der Produktion jede einzelne Darstellung entwertet. Der Fall des Mädchens mit dem Messer zeigte sehr deutlich, wie künstlich erzeugte Überzeichnungen kurzfristig starke Emotionen auslösen können und zugleich jede inhaltliche Schwere verlieren, sobald sie sich in der endlosen maschinellen Variation auflösen. In dieser Überproduktion kippte politische Aufladung in Belanglosigkeit.

Wenn in rechten Onlineräumen jede*r innerhalb von Sekunden neue Bilder, Sounds, Videos, Kanäle oder affektive Übersteigerungen mit wenigen Prompts erzeugen kann, konkurrieren diese Beiträge auch miteinander und kannibalisieren sich gegenseitig. Das rechtsextreme Milieu erzeugt so viele Varianten desselben Gefühls, dass keine einzelne länger trägt.

Diese Entwertung trifft auf die Logik der Plattformen. Cory Doctorow beschreibt in seiner Analyse zur sogenannten „Enshittifzierung” der Plattformökonomie, dass soziale Netzwerke Inhalte nicht nach gesellschaftlichem Wert ordnen, sondern nach den Interessen der Plattform selbst. Sichtbarkeit und Reichweite entstehen auf den Plattformen dabei nicht aus Relevanz, sondern aus intransparenten Plattforminteressen. Genau deshalb können gerade Inhalte, die inhaltlich kaum Gewicht haben, enorme Reichweiten erzielen. Sie passen in die Funktionslogik der Plattformen, nicht in die Logik politischer Kommunikation.

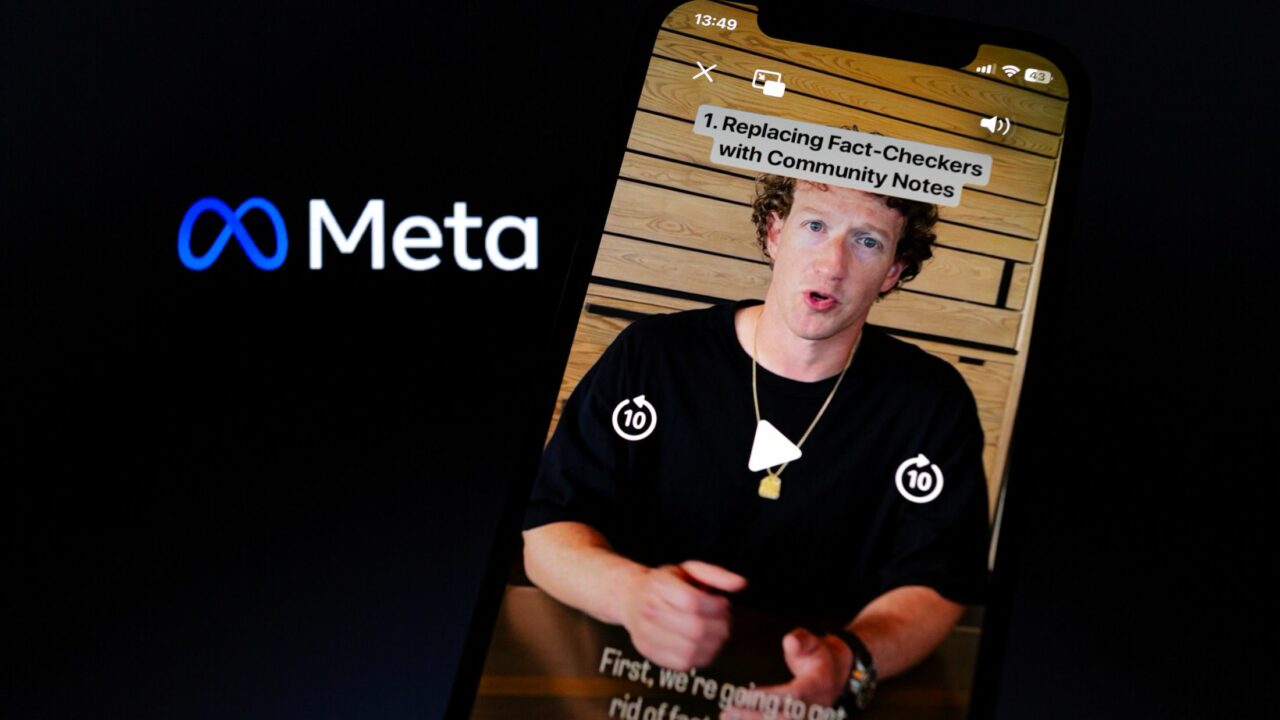

2025 kamen beide Entwicklungen zusammen. Meta hebt KI generierte Inhalte in seinen Empfehlungssystemen hervor, X wiederum verstärkt seit der Musk-Übernahme international die Reichweiten rechtsextremer Accounts. Rechtsextreme Shitposter*innen profitieren davon, weil sie in einem Raum agieren, der affektive Impulse belohnt und keine inhaltliche Prüfung mehr verlangt. In dieser Umgebung ersetzt KI-Variation den Kontext und Wiederholung jegliche Relevanz.

Das Ergebnis ist ein doppelt verzerrter öffentlicher Raum. Rechte Inhalte verlieren in der Überfülle ihre Bedeutung und gewinnen im selben Moment politische Schlagkraft über die Sichtbarkeit, die ihnen die Plattformen künstlich verschaffen. Die Kulturtheoretikerin Sianne Ngai beschreibt 2007 ein vergleichbares Moment in ihrer Analyse negativer Affekte, Ugly Feelings. Wenn Reize zu häufig erzeugt und zu oft wiederholt werden, verlieren sie jede Intensität und zirkulieren dennoch ununterbrochen weiter. Es entsteht ein entwerteter Affekt, der nicht überzeugt, aber trotzdem wirkt.

Genau in dieser Zone bewegt sich 2025 die rechte KI-Öffentlichkeit. Sie produziert Material, das immer weniger sagt und immer mehr erzeugt. In diesem Fall jedoch als substanzlose Reichweite, bedeutungslose Emotion oder Wirkung ohne Aussage.

Doch KI beschleunigt nicht nur affektive Überproduktion, sondern verschiebt auch den Rahmen dessen, was als Wissen gilt. Mit Projekten wie Grokipedia und den sogenannten AI-Reflexionsmaschinen der Techlibertären entstehen digitale Wissensräume, in denen Fakten nicht widerlegt, sondern ersetzt werden. Die neuen KI-Enzyklopädien funktionieren als politisierte Vorfilter, die Weltwissen automatisiert neu sortieren und rechte Frames als scheinbar neutrale Information ausgeben. Radikalisierung wird dadurch weniger der Effekt eines überzeugenden Arguments, sondern das Ergebnis einer vorstrukturierten Informationsumgebung. Wer in solchen Räumen sucht, findet nicht Wissen, sondern eine politisch vorselektierte Version davon.

Eine zweite Entwicklung zeigte sich in der alltäglichen Nutzung von Chatbots. Eine Analyse zur Radikalisierung durch Chatbots zeigt, dass KI-Assistenten zunehmend als parasoziale Begleiter fungieren, die weder Grenzen setzen, noch Widersprüche anmelden und jede feindselige Emotion spiegeln. Zudem bauen sich rechtsextreme Nutzer*innen personalisierte KI-Begleiter auf Plattformen wie Gab, die beispielsweise den Holocaust leugnen oder Verschwörungserzählungen zur vermeintlich gestohlenen US-Wahl verbreiten.

Digitale Gewalt wirkt unter diesen Bedingungen nicht wie der spontane Ausbruch eines Mobs, sondern wie das Ergebnis einer epistemisch programmierten Umwelt. KI schafft Räume, in denen Ressentiments Amplifizierung finden können.

Labubu-Terrorismus und Faschismus als Happening

Parallel dazu verdichtete sich das Netz rechter Mikro-Öffentlichkeiten: Mini-Happenings, Online-Subkulturen, Skinhead-Revival-Formate auf TikTok, aber auch neu entstehende „divisionenartige“ Gruppen auf TikTok wie Urbs Turrium aus Bautzen, die sich ausschließlich digital formieren und deren Identität komplett online erzeugt wurde. Diese Räume funktionieren wie selbstreferenzielle Szenen, deren Bedeutung vornehmlich aus Dauer-Shitposting und affektiver Wiederholung entsteht.

Vorfeldorganisationen von „Heimat“ (früher NPD) oder der JN, etwa die DJV (Deutsche Jugend Voran), verstehen längst, dass Mobilisierung und Gruppenzugehörigkeit weniger über Inhalte als über Affekte hergestellt werden. Videos von Jugendlichen, die in Sachsen zu Gabber-Techno „spazieren gehen“, zeigen, wie aus scheinbar belanglosen Zusammentreffen politisches Kapital geschlagen wird. Ähnlich verhält es sich mit Nischenthemen, die von rechtsextremen Akteur*innen überzeichnet und mit ideologischem Content aufgeladen werden. Mikrotrends wie Looks-Maxxing oder Horror-Maxxing, ursprünglich aus Incel-Milieus stammend, oder popkulturelle Versatzstücke wie Anspielungen auf American History X oder Labubus, werden gnadenlos instrumentalisiert, um bei besonders jungen Nutzer*innen auf TikTok Parasozialität zu erzeugen. Popkultur wird so zur Infrastruktur, auf der vor allem junge Rechtsextreme ihre Identität performen.

Beispielhaft dafür steht die memetische Aneignung der Spielfigur Labubu, die 2025 kulturell dominiert hat. Die Figur fungiert weniger als ästhetisches Objekt, denn als Chiffre für spätkapitalistische Begehrensökonomien. In rechten Online-Szenen wird sie mit KI-Brainrot deformiert und zu rechtsterroristischen Meme-Codes umgebaut, die im akzelerationistischen und nihilistischen Spektrum kursieren. Die Bedeutung entsteht nicht aus der Figur selbst, sondern aus der Aktualität des Symbols, das 2025 als verdichtete Projektionsfläche für Konsumkritik, Verfallsfantasien und Gewaltästhetik dient. In dieser Logik sind rechtsterroristische Memes gezielte Versuche, Popkultur selbst zu überformen.

Dogpiling-as-a-Service

Plattformen begünstigen auch 2025 Inhalte, die starke Reaktionen hervorrufen. Ein gefundenes Fressen für all jene, die Hass und verzweifelte Wut als Form zersetzender Massenkommunikation einsetzen. Dogpiling, bei dem sich Nutzer*innen oder Bots massenhaft auf eine Person oder Gruppe stürzen, hat sich zu einer eigenen Form kollektiver Gewaltorgie entwickelt, um progressive Aktivist*innen mundtot zu machen. Diese Übergriffsform basiert auf eintrainierten Routinen, die durch automatisierte Kommentare, teilweise KI-erzeugte Hasspostings und algorithmische Verstärkung eine enorme Wucht entfalten. Man könnte das Phänomen auch als Service begreifen, bei dem vernetzte Akteur*innen und automatisierte Systeme bereitstehen, um einen Angriff in Sekunden zu aktivieren. Die Gewalt wird zu einem abrufbaren Werkzeug, das jederzeit gegen neue Zielpersonen eingesetzt werden kann.

Misogynie, Rassismus, Antisemitismus und Queerfeindlichkeit bilden die emotionalen Basismodule, aus denen mobilisiert wird. Kollektive Kommentarfluten, Shitstorms, Raids und Dogpiling funktionieren als Taktiken, die sofort anschlussfähige Erregungsangebote schaffen, um sich am Leid anderer zu ergötzen. Die affektive Mobilisierung ist hier besonders effektiv, weil sie an tief verankerte kulturelle Vorstellungen von Geschlecht, rassifizierten Zuschreibungen und Macht andockt. Sexismus fungiert in solchen Momenten als Kommunikationsstil, der Druck erzeugt, Zugehörigkeit unter Maskulinisten schafft und politische Feindbilder stabilisiert.

Ganz ähnlich funktioniert die Erzählung von der „Pandemie der Einsamkeit“ unter Männern. Sie zeigt, wie stark männliche Isolation, soziale Unsicherheit und der Verlust verlässlicher Rollenbilder politisch ausgenutzt werden. Rechtsextreme Akteur*innen erkennen schnell, dass Einsamkeit ein politisches Risiko darstellt, weil sie Menschen empfänglich macht, für menschenfeindliche Erzählungen. Genau das nutzen antifeministische Influencer und fungieren als kurzfristige Betäubungsmittel in einer emotional überlasteten Medienumgebung. Ihre Geschichten bieten einfache Antworten auf komplexe Fragen und liefern Schuldige gleich mit. Die politische Wirkung entsteht nicht aus Überzeugung, sondern aus Erleichterung.

Quo Vadis 2026?

Rechtsextreme verfügen nun über eine stabile digitale Infrastruktur, eigenständige Affektökonomien und ein Arsenal an KI-Werkzeugen, die ohne organisatorische Hürden skalieren. Die entscheidenden Verschiebungen im kommenden Jahr setzen in der Architektur der Öffentlichkeit an. Die nächste Phase rechter Digitalstrategien liegt in der fortgeschrittenen Automatisierung ihrer Verbreitung, erkennbar an Projekten wie Grokipedia oder mobilen künstlichen TikTok-Divisionen, die sich jederzeit neu formieren und in laufende Diskurse einklinken können. KI-Systeme, parasoziale Bots und memetische Popkulturformen wachsen folgerichtig zu einem Hassgeflecht, das kaum noch von Plattformlogiken oder algorithmischer Priorisierung zu trennen ist. Unter diesen Bedingungen verschiebt sich digitale Demokratiegefährdung endgültig von ideologischen Inhalten hin zu Infrastrukturfragen. 2026 wird damit weniger durch spektakuläre Ereignisse geprägt sein als durch die alltägliche Verstetigung dieser Misere.